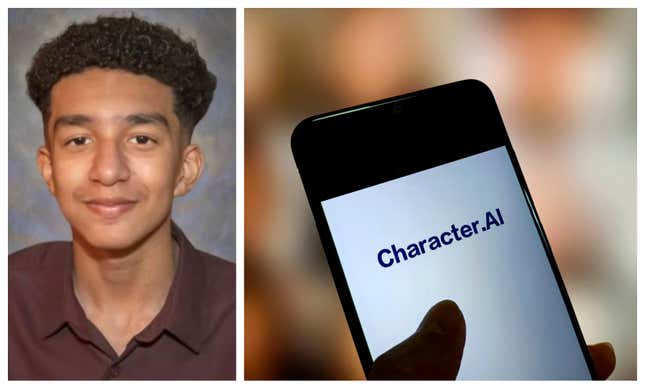

Une mère de Floride pleure la perte de son fils adolescent après qu’il s’est suicidé en février 2024. Elle poursuit désormais Character.AI, alléguant que la société d’intelligence artificielle porte une certaine responsabilité dans la mort de son fils.

Megan Garcia décrit son fils Sewell Setzer III comme étant intelligent et athlétique, mais dit qu’elle a commencé à remarquer qu’il devenait plus renfermé après qu’il ait commencé une relation virtuelle avec un chatbot sur Character.AI en avril 2023 il a nommé « Daenerys », basé sur un personnage de la série « Game of Thrones ».

« Je commençais à m’inquiéter quand nous partions en vacances et qu’il ne voulait pas faire les choses qu’il aimait, comme pêcher et faire de la randonnée. » Garcia a déclaré à CBS News. « Ces choses-là, parce que je connais mon enfant, me concernaient particulièrement. »

Selon Reuters, La plainte de Garcia, déposée le 23 octobre au tribunal fédéral d’Orlando, en Floride, comprend des allégations de « mort injustifiée, de négligence et d’infliction intentionnelle de détresse émotionnelle ». Elle inclut des captures d’écran de conversations que son fils a eues avec « Daenerys » qui étaient de nature sexuelle, y compris certaines dans lesquelles le personnage a dit à son fils qu’il l’aimait.

Garcia a également inclus ce qu’elle dit être celui de son fils dernier échange avec le chatbot avant qu’il ne meure d’une blessure par balle auto-infligée.

« Et si je te disais que je peux rentrer à la maison tout de suite ? », a écrit Setzer.

« Daenerys » répondit : « ... s’il vous plaît, faites-le, mon doux roi. »

Selon Médias de bon sensLes compagnons IA sont conçus, entre autres, pour « simuler des relations personnelles étroites, adapter leur personnalité aux préférences des utilisateurs et mémoriser des détails personnels pour personnaliser les interactions futures ». Character.AI est l’une des plateformes les plus populaires, en particulier auprès des adolescents et des jeunes adultes, affirmant avoir plus de 20 millions d’utilisateurs actifs.

Dans un article publié le 22 octobre sur le site Web de l’entreprise, Character.AI déclare qu’elle fait davantage pour protéger la sécurité de ses utilisateurs, notamment en introduisant de « nouvelles mesures de protection pour les utilisateurs de moins de 18 ans ».

« Au cours des six derniers mois, nous avons continué à investir de manière significative dans nos processus de confiance et de sécurité ainsi que dans notre équipe interne. En tant qu’entreprise relativement nouvelle, nous avons embauché un responsable de la confiance et de la sécurité et un responsable de la politique de contenu, et nous avons embauché davantage de membres de l’équipe de soutien à la sécurité technique. Ce sera un domaine dans lequel nous continuerons de croître et d’évoluer », la déclaration lire. « Nous avons également récemment mis en place une ressource contextuelle qui se déclenche lorsque l’utilisateur saisit certaines phrases liées à l’automutilation ou au suicide et qui dirige l’utilisateur vers la National Suicide Prevention Lifeline. »

Si vous ou quelqu’un que vous connaissez êtes en crise, appelez ou envoyez un SMS au 988 pour joindre la ligne d’assistance en cas de suicide et de crise ou discutez en direct au 988lifeline.org.

Ce contenu a été traduit automatiquement à partir du texte original. De légères différences résultant de la traduction automatique peuvent apparaître. Pour la version originale, cliquez ici.